Visitas: 12

El modelo reemplaza el laborioso proceso de anotar conjuntos de datos masivos de pacientes a mano.

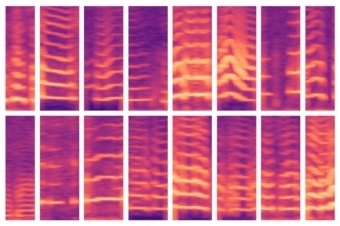

Fuente MIT por Rob Matheson | Un nuevo modelo desarrollado por el MIT automatiza un paso crítico en el uso de Inteligencia artificial para la toma de decisiones médicas, donde los expertos generalmente identifican a mano características importantes en conjuntos de datos masivos de pacientes. El modelo pudo identificar automáticamente los patrones de voz de las personas con nódulos de cuerdas vocales (que se muestran aquí) y, a su vez, usar esas características para predecir qué personas tienen y qué no tienen el trastorno.

Los científicos de la Computación esperan acelerar el uso de la Inteligencia Artificial para mejorar la toma de decisiones médicas, mediante la automatización de un paso clave que generalmente se hace a mano, y que se vuelve más laborioso a medida que ciertos conjuntos de datos crecen cada vez más.

El campo del análisis predictivo es cada vez más prometedor para ayudar a los médicos a diagnosticar y tratar pacientes. Los modelos de aprendizaje automático se pueden entrenar para encontrar patrones en los datos del paciente para ayudar en el cuidado de la sepsis, diseñar regímenes de quimioterapia más seguros y predecir el riesgo de un paciente de tener cáncer de mama o morir en la UCI, por nombrar solo algunos ejemplos.

Típicamente, los conjuntos de datos de entrenamiento consisten en muchos sujetos enfermos y sanos, pero con relativamente pocos datos para cada sujeto. Los expertos deben encontrar esos aspectos, o «características», en los conjuntos de datos que serán importantes para hacer predicciones.

Esta «ingeniería de características» puede ser un proceso laborioso y costoso. Pero se está volviendo aún más desafiante con el aumento de los sensores portátiles, porque los investigadores pueden monitorear más fácilmente la biometría de los pacientes durante largos períodos, siguiendo los patrones de sueño, la marcha y la actividad de la voz, por ejemplo. Después de solo una semana de monitoreo, los expertos podrían tener varios miles de millones de muestras de datos para cada tema.

En un artículo presentado en la conferencia Machine Learning for Healthcare esta semana, los investigadores del MIT demuestran un modelo que aprende automáticamente las características predictivas de los trastornos de las cuerdas vocales. Las características provienen de un conjunto de datos de aproximadamente 100 sujetos, cada uno con aproximadamente una semana de datos de monitoreo de voz y varios miles de millones de muestras; en otras palabras, una pequeña cantidad de sujetos y una gran cantidad de datos por sujeto. El conjunto de datos contiene señales capturadas desde un pequeño sensor acelerómetro montado en el cuello de los sujetos.

En experimentos, el modelo utilizó características extraídas automáticamente de estos datos para clasificar, con alta precisión, pacientes con y sin nódulos de cuerdas vocales. Estas son lesiones que se desarrollan en la laringe, a menudo debido a patrones de mal uso de la voz, como cantar o gritar. Es importante destacar que el modelo realizó esta tarea sin un gran conjunto de datos etiquetados a mano.

«Cada vez es más fácil recopilar conjuntos de datos de series temporales largas. Pero hay médicos que necesitan aplicar sus conocimientos para etiquetar el conjunto de datos ”, dice el autor principal, José Javier González Ortiz, estudiante de doctorado en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT. «Queremos eliminar esa parte manual para los expertos y descargar toda la ingeniería de características en un modelo de aprendizaje automático».

El modelo se puede adaptar para aprender patrones de cualquier enfermedad o afección. Pero la capacidad de detectar los patrones diarios de uso de la voz asociados con los nódulos de las cuerdas vocales es un paso importante en el desarrollo de mejores métodos para prevenir, diagnosticar y tratar el trastorno, dicen los investigadores. Eso podría incluir diseñar nuevas formas de identificar y alertar a las personas sobre comportamientos vocales potencialmente dañinos.

Junto a González Ortiz en el papel está John Guttag, profesor de Ciencias de la Computación e Ingeniería Eléctrica de Dugald C. Jackson y jefe del Grupo de Inferencia Dirigida por Datos de CSAIL; Robert Hillman, Jarrad Van Stan y Daryush Mehta, todos del Centro de Cirugía Laríngea y Rehabilitación de Voz del Hospital General de Massachusetts; y Marzyeh Ghassemi, profesora asistente de informática y medicina en la Universidad de Toronto.

Aprendizaje forzado de funciones

Durante años, los investigadores del MIT han trabajado con el Centro de Cirugía Laríngea y Rehabilitación de Voz para desarrollar y analizar datos de un sensor para rastrear el uso de la voz del sujeto durante todas las horas de vigilia. El sensor es un acelerómetro con un nodo que se adhiere al cuello y está conectado a un teléfono inteligente. Mientras la persona habla, el teléfono inteligente recopila datos de los desplazamientos en el acelerómetro.

En su trabajo, los investigadores recolectaron el valor de una semana de estos datos, llamados datos de «series temporales», de 104 sujetos, la mitad de los cuales fueron diagnosticados con nódulos de cuerdas vocales. Para cada paciente, también hubo un control de correspondencia, lo que significa un sujeto sano de edad, sexo, ocupación y otros factores similares.

Tradicionalmente, los expertos tendrían que identificar manualmente las características que pueden ser útiles para que un modelo detecte diversas enfermedades o afecciones. Eso ayuda a prevenir un problema común de aprendizaje automático en la atención médica: el sobreajuste. Es entonces cuando, en el entrenamiento, un modelo «memoriza» datos del asunto en lugar de aprender solo las características clínicamente relevantes. En las pruebas, esos modelos a menudo no logran discernir patrones similares en sujetos nunca vistos anteriormente.

“En lugar de aprender características que son clínicamente significativas, un modelo ve patrones y dice: ‘Esta es Sarah, y sé que Sarah está sana, y este es Peter, que tiene un nódulo de cuerda vocal’. Entonces, es solo memorizar patrones de sujetos. Luego, cuando ve datos de Andrew, que tiene un nuevo patrón de uso vocal, no puede determinar si esos patrones coinciden con una clasificación «, dice González Ortiz.

El desafío principal, entonces, evitar el sobreajuste mientras se automatizaba la ingeniería manual de características. Con ese fin, los investigadores obligaron al modelo a aprender características sin información del sujeto. Para su tarea, eso significaba capturar todos los momentos en que los sujetos hablan y la intensidad de sus voces.

A medida que su modelo rastrea los datos de un sujeto, está programado para localizar segmentos de voz, que comprenden solo aproximadamente el 10 por ciento de los datos. Para cada una de estas ventanas de voz, el modelo calcula un espectrograma, una representación visual del espectro de frecuencias que varía con el tiempo, que a menudo se usa para tareas de procesamiento de voz. Los espectrogramas se almacenan como grandes matrices de miles de valores.

Pero esas matrices son enormes y difíciles de procesar. Entonces, un auto codificador, una red neuronal optimizada para generar codificaciones de datos eficientes a partir de grandes cantidades de datos, primero comprime el espectrograma en una codificación de 30 valores. Luego descomprime esa codificación en un espectrograma separado. Inteligencia Artificial

Básicamente, el modelo debe garantizar que el espectrograma descomprimido se parezca mucho a la entrada del espectrograma original. Al hacerlo, se ve obligado a aprender la representación comprimida de cada entrada de segmento de espectrograma sobre los datos de series temporales de cada sujeto. Las representaciones comprimidas son las características que ayudan a entrenar modelos de aprendizaje automático para hacer predicciones.

Mapeo de características normales y anormales

En el entrenamiento, el modelo aprende a asignar esas características a «pacientes» o «controles». Los pacientes tendrán más patrones de voz que los controles. Al realizar pruebas en sujetos nunca vistos anteriormente, el modelo condenso de manera similar todos los segmentos del espectrograma en un conjunto reducido de características. Entonces, son las reglas de la mayoría: si el sujeto tiene segmentos de voz mayormente anormales, se clasifican como pacientes; si tienen en su mayoría normales, se clasifican como controles.

En los experimentos, el modelo funcionó con la misma precisión que los modelos de vanguardia que requieren ingeniería manual de características. Es importante destacar que el modelo de los investigadores se desempeñó con precisión tanto en la capacitación como en las pruebas, lo que indica que está aprendiendo patrones clínicamente relevantes de los datos, no de información específica del sujeto. Inteligencia Artificial

Luego, los investigadores quieren monitorear cómo diversos tratamientos, como la cirugía y la terapia vocal, impactan el comportamiento vocal. Si el comportamiento de los pacientes se mueve de anormal a normal con el tiempo, lo más probable es que estén mejorando. También esperan utilizar una técnica similar en los datos del electrocardiograma, que se utiliza para rastrear las funciones musculares del corazón.

Dejar una contestacion