Visitas: 13

– El zapato de la empresa Tec-Innovation advierte a las personas ciegas y con discapacidad visual de los obstáculos gracias a los sensores ultrasónicos. Los informáticos de TU Graz han desarrollado un sistema de reconocimiento de imágenes de IA basado en cámaras para este propósito.

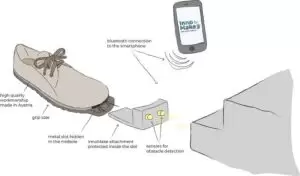

Courtesy TU Graz: Un zapato que te dice adónde ir. La empresa de Baja Austria Tec-Innovation ha desarrollado un zapato inteligente para detectar obstáculos. El zapato, conocido como InnoMake, se ha comercializado recientemente como un dispositivo médico aprobado y está destinado a hacer más segura la movilidad personal de los ciegos y con discapacidad visual. «Los sensores ultrasónicos en la punta del zapato detectan obstáculos hasta a cuatro metros de distancia. El usuario es advertido por vibraciones y / o señales acústicas. Esto funciona muy bien y ya es una gran ayuda para mí personalmente», dice Markus Raffer, uno de los fundadores de Tec-Innovation y él mismo con discapacidad visual.

El equipo dirigido por Raffer y su socio fundador Kevin Pajestka determinó al principio de la fase de desarrollo que dos piezas de información avanzada son extremadamente importantes para la usabilidad: la naturaleza de un obstáculo y su trayectoria direccional, especialmente si está mirando hacia abajo, como agujeros o escaleras. «No solo es relevante la advertencia de que estoy enfrentando un obstáculo, sino también la información sobre el tipo de obstáculo que estoy enfrentando. Porque hace una gran diferencia si se trata de una pared, un automóvil o una escalera», dice Raffer.

AI reconoce áreas transitables

Después de una búsqueda activa, Tec-Innovation pudo ganarse a la Universidad Tecnológica de Graz (TU Graz) como socio de cooperación en 2016. Desde entonces, el Instituto de Gráficos y Visión por Computadora ha estado trabajando en una adición basada en cámaras para la primera versión del producto, como explica el científico informático Friedrich Fraundorfer: «Hemos desarrollado algoritmos de aprendizaje profundo de última generación modelados en redes neuronales que pueden hacer dos cosas principales después de detectar e interpretar el contenido de la imagen. imágenes desde la perspectiva del pie para determinar un área libre de obstáculos y, por lo tanto, segura para caminar. Y pueden reconocer y distinguir objetos «. Los algoritmos entrenados mediante el aprendizaje automático ya se pueden operar en un sistema móvil especialmente diseñado. Gracias a los últimos y potentes procesadores especiales, ahora también es posible el uso móvil de los complejos algoritmos de IA. «Esto se puede atribuir al enorme desarrollo del procesador de los últimos años», añade David Schinagl, colega de Fraundorfer. El algoritmo TU Graz está patentado y se ha transferido a Tec-Innovation.

Fusionar datos en un mapa de navegación

Tec-Innovation ahora está trabajando en la integración del sistema en un prototipo; la cámara y el procesador deben estar integrados de forma robusta y cómoda en el zapato. Friedrich Fraundorfer y su equipo en TU Graz, a su vez, ya han pasado a la siguiente etapa como la continuación lógica del proyecto. Quieren combinar la información recopilada mientras usan el zapato en términos de conocimiento del enjambre en una especie de mapa de navegación de Street View para personas con discapacidad visual. «Tal como está actualmente, solo el usuario se beneficia en cada caso de los datos que el zapato recopila mientras camina. Sería mucho más sostenible si estos datos también pudieran estar disponibles para otras personas como una ayuda para la navegación», dice Fraundorfer.

Para la concepción y la implementación prototípica de un mapa de Street View para personas ciegas y con discapacidad visual, se está presentando una solicitud de financiación a la Agencia Austriaca de Promoción de la Investigación FFG. Debido a los enormes desafíos que enfrenta, este tipo de soporte de navegación aún está en un futuro lejano.

Según Fraundorfer, los mayores puntos conflictivos son la actualización y expansión del mapa que se necesitan continuamente, vinculándolo con datos anteriores y la conexión de TI del sistema de calzado. Para el investigador de TU Graz, sin embargo, una cosa es segura: “Definitivamente continuaremos en el tema. Después de todo, en nuestro mundo altamente innovador, también debe ser posible una alternativa al bastón para ciegos de más de 70 años «.

Esta investigación se basa en el «campo de la información, la comunicación y la informática de especialización», uno de los cinco focos de investigación en TU Graz.

Contacto: Friedrich FRAUNDORFER – Prof. Asociado Dipl.-Ing. Dr.techn. TU Graz | Instituto de Gráficos y Visión por Computadora / fraundorfer@icg.tugraz.at

Markus RAFFER: Tec-Innovación | CEO / m.raffer@tec-innovation.com – www.tec-innovation.com

Artículo relacionado: Tecnología permite que memes sean accesibles para personas con discapacidad visual

Dejar una contestacion