Visitas: 277

– El sistema de imágenes permite a los usuarios probarse trajes virtuales en tiempo real

Cortesía de la Universidad de Tokio: un equipo de investigadores de la Universidad de Tokio ha creado una forma para que las personas se visualicen con prendas de vestir a las que no tienen acceso físico directo. El sistema de probador virtual utiliza un dispositivo de captura único y una forma impulsada por inteligencia artificial (AI) para digitalizar prendas de vestir.

Usando un sistema de imagen y visualización correspondiente, un usuario puede verse a sí mismo en una pantalla vistiendo cualquier cosa del guarda ropa digital. Un motor de inteligencia artificial sintetiza imágenes fotorrealistas, lo que permite que el movimiento y los detalles como pliegues y ondulaciones se vean como si el usuario realmente estuviera usando la ropa virtual.

A veces, comprar ropa puede ser difícil. A menudo llegas a la tienda y están fuera del estilo o del tamaño de la prenda que pretendías probarte por ti mismo. Ahora se pueden hacer muchas compras en línea, pero comprar ropa puede ser difícil, ya que es muy difícil juzgar qué tan bien le quedará algo o si le gustará una vez que lo vea en persona.

Para abordar estos problemas, ha habido algunos intentos a lo largo de los años para crear una especie de espejo digital que pueda visualizar a un usuario y superponer una prenda de vestir encima de él. Sin embargo, estos sistemas carecen de funcionalidad y realismo.

El profesor Takeo Igarashi del Grupo de Investigación de la Interfaz de Usuario de la Universidad de Tokio y su equipo exploran diferentes formas en que los humanos pueden interactuar con las computadoras. Sentían que podían crear su propio espejo digital que resuelve algunas limitaciones de los sistemas anteriores. Su respuesta es el sistema de provador virtual, y el equipo espera que pueda cambiar la forma en que compramos ropa en el futuro.

“El problema de crear un espejo digital preciso es doble”, dijo Igarashi. “En primer lugar, es importante modelar una amplia gama de prendas en diferentes tamaños. Y en segundo lugar, es esencial que estas prendas se puedan superponer de manera realista a un video del usuario. Nuestra solución es única en la forma en que funciona mediante el uso de un maniquí robótico a medida y una IA de última generación que traduce la ropa digitalizada para su visualización «.

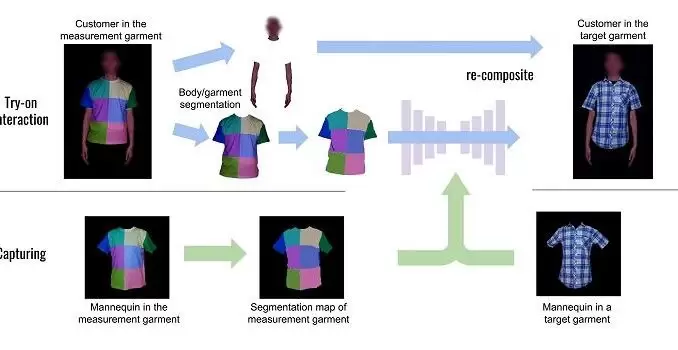

Para digitalizar las prendas, el equipo diseñó un maniquí que puede moverse, expandirse y contraerse de diferentes maneras para reflejar diferentes poses y tamaños corporales. Un fabricante tendría que vestir a este maniquí robótico con una prenda y luego permitirle recorrer una variedad de poses y tamaños mientras las cámaras lo capturan desde diferentes ángulos.

Las imágenes capturadas se envían a una IA que aprende a traducirlas para adaptarse a un usuario aún no visto. En la actualidad, la captura de imágenes de un artículo toma alrededor de dos horas, pero una vez que alguien ha vestido el maniquí, el resto del proceso se automatiza.

«Aunque el tiempo de captura de imágenes es de solo dos horas, el sistema de aprendizaje profundo que hemos creado para entrenar modelos para visualización posterior tarda alrededor de dos días en completarse», dijo el estudiante graduado Toby Chong, uno de los coautores del artículo. «Sin embargo, este tiempo naturalmente disminuirá a medida que aumente el rendimiento computacional».

Luego viene la interacción del usuario. Alguien que desee probarse ropa diferente tendría que ir a la tienda y pararse frente a una cámara y una pantalla. Se pondrían un atuendo hecho especialmente con un patrón inusual llamado prenda de medición.

El patrón es una disposición no repetida de cuadrados de diferentes colores. La razón de esto es que es fácil para una computadora estimar cómo se posiciona el cuerpo de una persona en el espacio de acuerdo con cómo estos cuadrados de colores se mueven entre sí. A medida que el usuario se mueve, la computadora sintetiza una imagen plausible de la prenda que sigue el movimiento del usuario.

“Una ventaja de nuestro sistema es que la prenda virtual coincide con el movimiento de la prenda de medición, incluidas cosas como arrugas o estiramientos. De hecho, puede parecer muy realista ”, dijo Igarashi. “Sin embargo, todavía hay algunos aspectos que queremos mejorar.

Por ejemplo, en la actualidad, las condiciones de iluminación en el entorno del usuario deben controlarse estrictamente. Sería mejor si pudiera funcionar bien en situaciones de rayos menos controlados. Además, hay algunos artefactos visuales que tenemos la intención de corregir, como pequeños huecos en los bordes de las prendas «.

El equipo tiene varias aplicaciones posibles en mente, siendo las compras en línea la más obvia, con un beneficio adicional que podría evitar una gran cantidad de desperdicio de moda, ya que los compradores podrían tener una mayor seguridad sobre su compra y la ropa podría incluso fabricarse a pedido en lugar de en escala.

Pero al provador virtual también podría resultar útil en el mundo del vídeo en línea, incluidas las conferencias y la producción reuniones, donde la apariencia es importante y los presupuestos son ajustados. Desde luego el probador virtual seria un recurso temporario, para evitar gastos con ropa !!

Artículo relacionado: Software para textiles para acelerar el desarrollo de ropa

Dejar una contestacion